免费下载

夸克:https://pan.quark.cn/s/be4acf58b59d

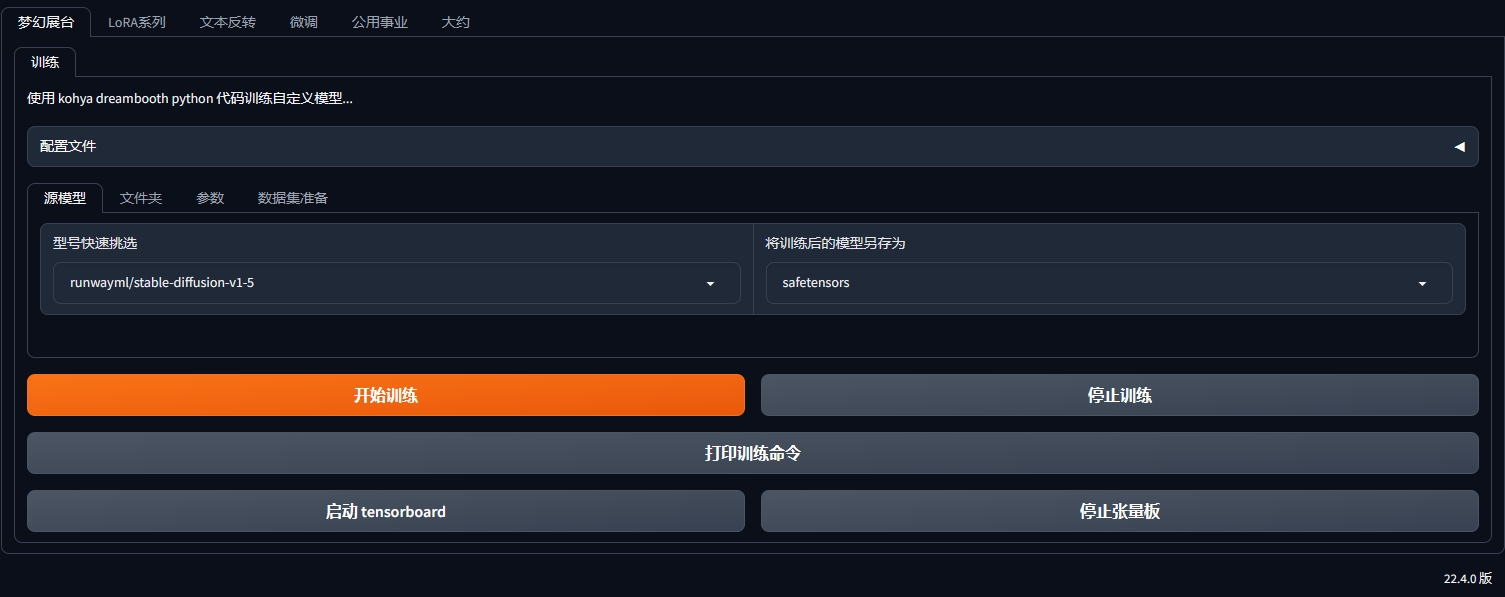

Kohya_ss 是一个元老级的模型训练器,主要为Stable Diffusion训练提供以 Windows 为中心的 Gradio GUI……但对 Linux 操作系统的支持也是通过社区贡献提供的。目前对Macos不是很友好。

GUI 允许您设置训练参数,并生成和运行所需的 CLI 命令来训练模型。

右边的下载包里包含了

- kohya_ss-v22.4.0版本

- Git-2.43.0-64位版本

- python-3.10.9版本

安装

windows安装条件

若要在 Windows 系统上安装必要的依赖项,请按照下列步骤操作:

安装 Python 3.10。

- 在安装过程中,请确保选择将 Python 添加到“PATH”环境变量的选项。

安装 Git。

安装命令

若要设置项目,请按照下列步骤操作:

打开终端并导航到所需的安装目录。

通过运行以下命令克隆存储库:

git clone https://github.com/bmaltais/kohya_ss.git

切换到目录:kohya_ss

cd kohya_ss

通过执行以下命令运行安装脚本:

.\setup.bat

SDXL训练参数

- SDXL 的默认分辨率为 1024×1024。

- 可以使用 24GB GPU 内存、批量大小为 1 进行微调。对于 24GB GPU,建议使用以下选项来使用 24GB GPU 内存进行微调:

- 仅训练 U-Net。

- 使用梯度检查点。

- 使用

--cache_text_encoder_outputs选项和缓存潜在变量。 - 使用 Adafactor 优化器。RMSprop 8bit 或 Adagrad 8bit 可能有效。AdamW 8bit 似乎不起作用。

- LoRA 训练可以使用 8GB GPU 内存(推荐 10GB)完成。为了减少 GPU 内存使用,建议使用以下选项:

- 仅训练 U-Net。

- 使用梯度检查点。

- 使用

--cache_text_encoder_outputs选项和缓存潜在变量。 - 使用 8 位优化器或 Adafactor 优化器之一。

- 使用较低的暗度(8GB GPU 为-8)。

--network_train_unet_only强烈建议选择 SDXL LoRA。由于SDXL有两个文本编码器,因此训练的结果将是意想不到的。- PyTorch 2 使用的 GPU 内存似乎比 PyTorch 1 略少。

--bucket_reso_steps可以设置为 32 而不是默认值 64。小于 32 的值将不适用于 SDXL 训练。

具有固定学习率的 Adafactor 优化器设置示例:

optimizer_type = "adafactor"

optimizer_args = [ "scale_parameter=False", "relative_step=False", "warmup_init=False" ]

lr_scheduler = "constant_with_warmup"

lr_warmup_steps = 100

learning_rate = 4e-7 # SDXL original learning rate

在加速配置步骤中,除非您知道硬件需求,否则请使用配置期间建议的默认值。GPU 上的 VRAM 量对使用的值没有影响。

可选:CUDNN 8.6

以下步骤是可选的,但可以提高 NVIDIA 30X0/40X0 GPU 所有者的学习速度。这些步骤可实现更大的训练批次大小和更快的训练速度。

请注意,由于文件大小限制,此过程所需的 CUDNN 8.6 DLL 无法托管在 GitHub 上。您可以在此处下载它们以提高样本生成速度(在 4090 GPU 上几乎为 50%)。

下载ZIP文件后,请按照以下安装步骤操作:

解压缩下载的文件,并将该文件夹放在存储库的根目录中。cudnn_windowskohya_ss

运行 .\setup.bat 并选择安装 cudann 的选项。

© 版权声明

文章版权归作者所有,未经允许请勿转载。